Pangu Ultra MoE 是一個全流程在昇騰 NPU 上訓練的準萬億 MoE 模型,此前發布了英文技術報告[1]。最近華為盤古團隊發布了 Pangu Ultra MoE 模型架構與訓練方法的中文技術報告,進一步披露了這個模型的細節。

訓練超大規模和極高稀疏性的 MoE 模型極具挑戰,訓練過程中的穩定性往往難以保障。針對這一難題,盤古團隊在模型架構和訓練方法上進行了創新性設計,成功地在昇騰 NPU 上實現了準萬億 MoE 模型的全流程訓練。

盤古團隊提出 Depth-Scaled Sandwich-Norm(DSSN)穩定架構和 TinyInit 小初始化的方法,在昇騰 NPU 上實現了 10+ T tokens 數據的長期穩定訓練。此外,他們還提出了 EP group loss 負載優化方法,這一設計不僅保證了各個專家之間能保持較好的負載均衡,也提升了專家的領域特化能力。同時,Pangu Ultra MoE 使用了業界先進的 MLA 和 MTP 架構,在訓練時使用了 Dropless 訓練策略。

-

技術報告標題:Pangu Ultra MoE 模型架構與訓練方法

-

技術報告地址:https://raw.gitcode.com/ascend-tribe/pangu-ultra-moe/raw/main/Pangu_Ultra_MoE_CN_Report.pdf

破解準萬億 MoE 模型性能瓶頸

打造芯片協同的先進架構

近期,盤古團隊在 MoE 模型訓練領域再進一步,重磅推出參數規模高達 718B 的準萬億全新模型 ——Pangu Ultra MoE。該模型旨在實現超大規模 MoE 架構在模型效果與效率之間的最佳平衡。

為了達到這個目標,研究團隊在設計 Pangu Ultra MoE 架構的時候,充分考慮昇騰硬件特性,在昇騰 NPU 平臺上,融合計算、通信和內存等多維度指標,構建了大規模系統模擬器,并系統性地探索約一萬個不同的 MoE 結構組合,最終搜索出一套在訓練與推理吞吐上均達最優的架構方案。

Pangu Ultra MoE 是一個超大規模、高稀疏比的架構,同時也包含 MLA 和 MTP 等先進架構和特有的 DSSN 穩定性架構和 EP group loss 負載優化。下面是 Pangu Ultra MoE 的主要的架構和訓練特性:

-

超大規模和超高稀疏比:采用 256 個路由專家,每個 token 激活 8 個專家,模型總參數量 718B,激活量 39B。

-

MLA 注意力機制:引入 MLA(Multi-head Latent Attention),有效壓縮 KV Cache 空間,緩解推理階段的內存帶寬瓶頸,優于傳統 GQA 方案。

-

MTP 多頭擴展:采用單頭 MTP 進行訓練,后續復用 MTP 參數擴展至多頭結構,實現多 Token 投機推理,加速整體推理過程。

-

Dropless 訓練:采用 Dropless 訓練可以避免 Drop&Pad 訓推不一致問題,并且提升訓練的數據效率。

-

RL 訓練:采用迭代難例挖掘與多能力項均衡的獎勵函數,并參考 GRPO 算法,提升了模型的訓練效率與最終推理性能。

以下是 Pangu Ultra MoE 昇騰親和設計考慮:

-

隱藏維度貼合硬件:設置 7680 維隱藏層,精準匹配昇騰芯片的 16×16 MatMul 單元,充分發揮 Cube 核心的計算潛力。

-

層數親和流水線并行:設置 61 層 Transformer 結構,并預留額外 MTP 層空間,保障計算負載均衡的 PP/VPP 流水線調度,減少 pipeline 氣泡,提升整體并行效率。

-

專家規模符合冪次規律:路由專家數量設為2?=256,在 TP×EP 并行下提升 All-to-All 通信效率,有效加速分布式訓練。

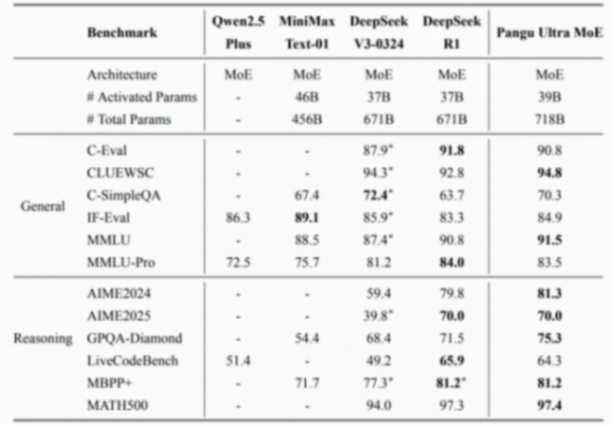

Pangu Ultra MoE 的預訓練階段在 6k 到 10k 張 NPU 上進行,全流程采用 dropless 訓練模式。預訓練階段進行了長序列擴展,最終模型具備 128k 長序列能力。在后訓練階段,Pangu Ultra MoE 移除了負載均衡輔助損失,保留專家間已有的特化能力,從而進一步提升模型對目標數據的學習效率。如表1所示,最終模型在多個權威開源評測集上展現出一流的效果。